Los sindicatos de estafadores se están globalizando y están optando por la alta tecnología.

Lo que solía ser un ajetreo callejero ahora es una operación multimillonaria impulsada por inteligencia artificial generativa y carteras criptográficas anónimas. A medida que los gobiernos del este y sudeste asiático toman medidas enérgicas contra las redes de fraude locales, estos grupos delictivos no se retiran, sino que se reinventan.

Según un informe* de la Oficina de las Naciones Unidas contra la Droga y el Delito, la delincuencia organizada se está convirtiendo en un industria tecnológica globalizada, con centros de estafa que industrializan sus métodos y blanquean miles de millones a través de las fronteras. La web oscura, la falsificación impulsada por la inteligencia artificial y la banca clandestina se han convertido en herramientas en esta nueva economía de la delincuencia digital.

¿Y una de las herramientas más peligrosas de todas? Deepfake.

Cómo engañan los estafadores a los sistemas de verificación

Deepfake, abreviatura de «aprendizaje profundo y falso», ya no es solo un generador de memes virales, sino un arma de referencia en el manual de estrategias de los estafadores. Gracias a la inteligencia artificial, los deepfakes pueden convertir solo unas cuantas fotos en vídeos realistas, con parpadeos naturales, inclinaciones de la cabeza e incluso microexpresiones. Lo que antes se utilizaba en un estudio de efectos visuales ahora se puede hacer en un portátil. Esto podría ser una mala noticia para cualquiera que confíe únicamente en el reconocimiento facial en 2D.

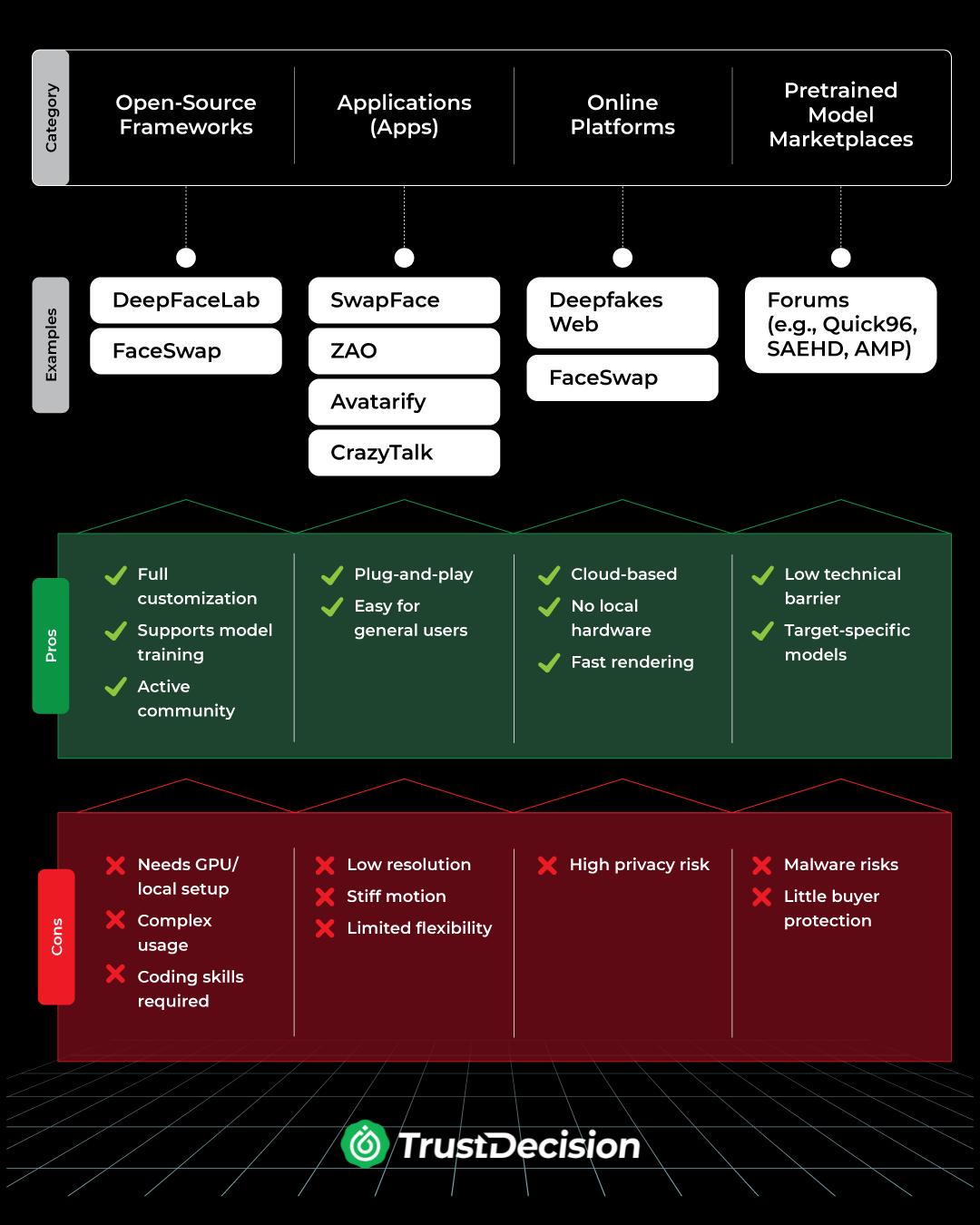

Deepfake Tools: ¿Qué hay ahí fuera?

Desde el código fuente abierto hasta las aplicaciones listas para usar, los estafadores de hoy tienen una caja de herramientas completa. He aquí un desglose:

Cómo se diseñan los deepfakes para eludir la verificación biométrica

Una vez equipados con las herramientas adecuadas, los atacantes ponen en marcha su plan. A continuación, te explicamos paso a paso cómo se diseñan los vídeos sintéticos para eludir los sistemas de autenticación facial:

- Recopilación de datos — El estafador identifica a un objetivo y utiliza tácticas de suplantación de identidad o ingeniería social para obtener sus datos biométricos, como fotos, vídeos o muestras de voz.

- Modelado dinámico — Con los datos recopilados, el atacante construye un modelo que replica las características faciales y los movimientos del objetivo.

- Renderización de vídeo — Con ese modelo, crean una animación realista, a menudo mejorada con efectos de iluminación especiales (como superposiciones RGB), para imitar las velocidades naturales de parpadeo y los movimientos de la cabeza, evitando así la detección de vida en 2D.

- Ejecución del ataque — Luego, el video falso se inyecta en una videollamada o se carga en un sistema de verificación biométrica. Aprovechando fallos como la detección de parpadeos basada en fotogramas, el sistema es engañado y el atacante se hace pasar por el usuario real.

La respuesta empresarial a las amenazas de Deepfake

A medida que los ataques de deepfake se vuelven más sofisticados, es fundamental que las empresas vayan más allá de las comprobaciones KYC tradicionales. Las organizaciones líderes ahora están adoptando defensas inteligentes de varios niveles para identificar las manipulaciones antes y responder más rápido.

Reforzar la protección de cuentas

Al supervisar el comportamiento de inicio de sesión, los patrones de los dispositivos y las anomalías de acceso, las empresas pueden detectar amenazas como los troyanos de acceso remoto (RAT) o el robo de credenciales incluso antes de que comience la verificación de identidad.

Mejora de las defensas biométricas con IA

Los sistemas biométricos modernos aprovechan la inteligencia artificial para detectar inconsistencias sutiles en la dinámica facial, yendo mucho más allá de la detección básica de parpadeo o movimiento para detectar intentos de realizar una falsificación profunda.

Integración de la inteligencia de dispositivos

Las señales de los terminales, como el uso de emuladores, los restablecimientos frecuentes o los desajustes de hardware, se utilizan cada vez más para descubrir dispositivos falsificados y detener el fraude en su origen.

Modelando el comportamiento en contexto

Los vídeos sintéticos pueden imitar las apariencias, pero no el comportamiento real. Al combinar las bases de referencia del comportamiento con la inteligencia externa, las organizaciones pueden crear perfiles de riesgo dinámicos y detectar actividades sospechosas en tiempo real.

Obtenga más información sobre cómo funciona el fraude con DeepFake y cómo mantenerse a la vanguardia en nuestro último vídeo De los deepfakes a los préstamos falsos: la nueva cara del fraude crediticio.

Referencias

Oficina de las Naciones Unidas contra la Droga y el Delito. (2025). Punto de inflexión: implicaciones globales de los centros de estafa, la banca clandestina y los mercados ilícitos en línea en el sudeste asiático. https://www.unodc.org/roseap/uploads/documents/Publications/2025/Inflection_Point_2025.pdf

.jpeg)